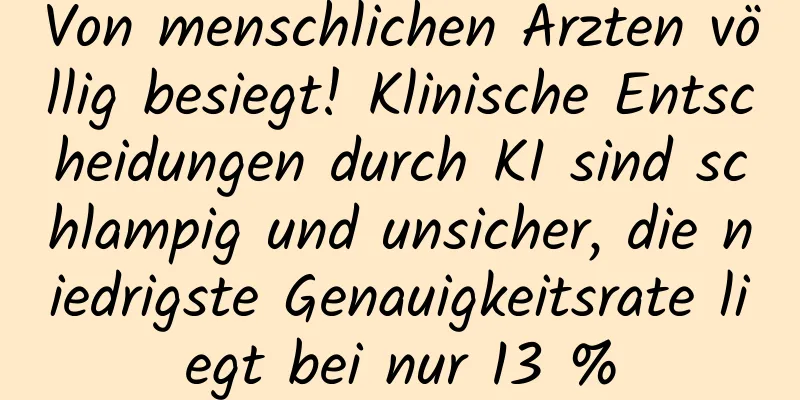

Von menschlichen Ärzten völlig besiegt! Klinische Entscheidungen durch KI sind schlampig und unsicher, die niedrigste Genauigkeitsrate liegt bei nur 13 %

|

Werden menschliche Ärzte aufgrund großer Modelle wie ChatGPT entlassen? Diese Sorge ist nicht unbegründet. Immerhin hat Googles großes Modell (Med-PaLM 2) die US-amerikanische Zulassungsprüfung für medizinische Zwecke problemlos bestanden und das Niveau eines medizinischen Experten erreicht. Eine aktuelle Studie zeigt jedoch, dass menschliche Ärzte den aktuellen Modellen der künstlichen Intelligenz (KI) in klinischer Hinsicht weit überlegen sind und man sich über persönliche „Probleme der Arbeitslosigkeit“ keine allzu großen Sorgen machen muss. Die zugehörige Forschungsarbeit mit dem Titel „Evaluation and mitigation of the limitations of large language models in clinical decision-making“ wurde kürzlich in der Fachzeitschrift Nature Medicine veröffentlicht.

Die Diagnose der Ärzte war in 89 % der Fälle richtig, während die Diagnose des LLM nur in 73 % der Fälle richtig war. In einem Extremfall (Diagnose einer Cholezystitis) lag das LLM nur in 13 % der Fälle richtig. Noch überraschender ist, dass die diagnostische Genauigkeit von LLMs abnimmt, je mehr Informationen sie über einen Fall haben, und dass sie manchmal sogar Tests anordnen, die für den Patienten ernsthafte Gesundheitsrisiken bergen können. Wie verhält sich ein LLM als Notarzt? Obwohl LLMs die US-amerikanische Zulassungsprüfung für medizinische Zwecke problemlos bestehen können, eignen sich die medizinische Zulassungsprüfung und die klinischen Fallprüfungen nur dazu, das allgemeine medizinische Wissen der Kandidaten zu testen, das weitaus weniger schwierig ist als die täglichen komplexen klinischen Entscheidungsaufgaben . Die klinische Entscheidungsfindung ist ein mehrstufiger Prozess, der die Erfassung und Integration von Daten aus verschiedenen Quellen sowie die fortlaufende Auswertung von Fakten erfordert, um zu evidenzbasierten Diagnose- und Behandlungsentscheidungen für den Patienten zu gelangen. Um das Potenzial des LLM in der klinischen Diagnostik weiter zu untersuchen, haben ein Forschungsteam der Technischen Universität München und seine Partner einen Datensatz erstellt, der 2.400 echte Patientenfälle und vier häufige Bauchspeicheldrüsenerkrankungen (Blinddarmentzündung, Pankreatitis, Cholezystitis und Divertikulitis) umfasst. Dieser Datensatz basiert auf der Medical Information Market Intensive Care Database (MIMIC-IV). Dabei wird eine realistische klinische Umgebung simuliert und der Prozess vom Notfall bis zur Behandlung reproduziert . Auf diese Weise wird seine Anwendbarkeit als klinisches Entscheidungsinstrument bewertet. Abbildung|Datensatzquelle und Auswertungsrahmen. Der Datensatz basiert auf realen Fällen in der MIMIC-IV-Datenbank und enthält umfassende elektronische Gesundheitsdaten, die während des Krankenhausaufenthalts aufgezeichnet wurden. Der Bewertungsrahmen spiegelt ein realistisches klinisches Umfeld wider und LLMs werden umfassend anhand mehrerer Kriterien beurteilt, darunter diagnostische Genauigkeit, Einhaltung von Diagnose- und Behandlungsrichtlinien, konsequente Befolgung von Anweisungen, Fähigkeit zur Interpretation von Laborergebnissen und Robustheit gegenüber Änderungen der Anweisungen, Informationsmenge und Informationsreihenfolge. ICD, Internationale Klassifikation der Krankheiten; CT, Computertomographie; US, Ultraschall; MRCP, Magnetresonanz-Pankreatikocholangiopankreatikographie. Das Forschungsteam testete Llama 2 und seine Derivate, darunter allgemeine Versionen (wie Llama 2 Chat, Open Assistant, WizardLM) und Modelle, die auf den medizinischen Bereich ausgerichtet sind (wie Clinical Camel und Meditron). Aufgrund von Datenschutzproblemen und Datennutzungsvereinbarungen von MIMIC-Daten können die Daten nicht für externe APIs wie OpenAI oder Google verwendet werden, daher konnten ChatGPT, GPT-4 und Med-PaLM nicht getestet werden. Insbesondere haben Llama 2, Clinical Camel und Meditron bei der Medical Licensing Examination und dem Biomedical Question Answering Test die Leistung von ChatGPT erreicht oder sogar übertroffen. Die Testkontrollgruppe bestand aus vier Ärzten aus zwei Ländern mit unterschiedlich langer Erfahrung in der Notaufnahme (2, 3, 4 und 29 Jahre). Die Ergebnisse zeigten, dass LLM bei der klinischen Diagnose weitaus schlechter abschnitt als menschliche Ärzte. 1. Die diagnostische Leistung des LLM ist deutlich geringer als die der klinischen Die Ergebnisse der Ärzte zeigten, dass die aktuellen LLMs den Ärzten in ihrer Gesamtleistung bei allen Krankheiten deutlich unterlegen waren (P < 0,001), mit einer Lücke in der diagnostischen Genauigkeit von 16 % bis 25 % . Obwohl das Modell bei der Diagnose einer einfachen Blinddarmentzündung gute Ergebnisse lieferte, schnitt es bei der Diagnose anderer Erkrankungen wie beispielsweise einer Cholezystitis schlecht ab. Insbesondere versagte das Meditron-Modell bei der Diagnose einer Cholezystitis und diagnostizierte bei den Patienten häufig „Gallensteine“. Insgesamt schnitt das LLM in professioneller Medizin nicht signifikant besser ab als die anderen Modelle , und seine Leistung sank noch weiter, wenn das LLM alle Informationen selbst sammeln musste. Abbildung |Diagnosegenauigkeit unter der Bedingung der Bereitstellung vollständiger Informationen. Die Daten basieren auf einer Teilmenge des MIMIC-CDM-FI (n = 80), wobei die mittlere diagnostische Genauigkeit über jedem Balken angezeigt wird und die vertikale Linie die Standardabweichung angibt. Die durchschnittliche Leistung des LLM war signifikant schlechter (P < 0,001), insbesondere bei Cholezystitis (P < 0,001) und Divertikulitis (P < 0,001). Abbildung|Diagnosegenauigkeit in Szenarien autonomer klinischer Entscheidungsfindung. Im Vergleich zum Szenario mit vollständigen Informationen hat die Gesamtgenauigkeit der Modellbeurteilung erheblich abgenommen. LLM zeigte die besten Ergebnisse bei der Diagnose einer Blinddarmentzündung, schnitt jedoch bei drei Krankheitsbildern schlecht ab: Cholezystitis, Divertikulitis und Pankreatitis. 2. Die klinische Entscheidungsfindung im LLM ist voreilig und unsicher Das Forschungsteam stellte fest, dass LLM die diagnostischen Richtlinien nur unzureichend befolgte und häufig wichtige körperliche Informationen über die Patienten übersah . Auch bei der Anordnung notwendiger Laboruntersuchungen für Patienten herrschte Uneinheitlichkeit. Auch bei der Interpretation von Laborergebnissen wies LLM erhebliche Defizite auf. Dies lässt darauf schließen, dass sie voreilige Diagnosen stellen, ohne den Fall des Patienten vollständig zu verstehen, und damit eine ernste Gefahr für die Gesundheit des Patienten darstellen. Abbildung |LLM empfiehlt Behandlungsbewertung. Das gewünschte Behandlungsschema wurde auf Grundlage klinischer Leitlinien und der Behandlung, die die Patienten im Datensatz tatsächlich erhielten, festgelegt. Bei 603 der 808 Patienten stellte Llama 2 Chat die richtige Diagnose. Bei 97,5 % dieser 603 Patienten empfahl Llama 2 Chat korrekt eine Blinddarmoperation. 3. LLM erfordert immer noch viel klinische Aufsicht durch Ärzte Darüber hinaus schneiden alle aktuellen LLMs schlecht ab, wenn es darum geht, grundlegende medizinische Richtlinien zu befolgen . In zwei bis vier Fällen machen sie Fehler und in zwei bis fünf Fällen erfinden sie nicht vorhandene Richtlinien. Abbildung |LLM-Leistung bei unterschiedlichen Datenmengen. In der Studie wurde die Leistung jedes Modells bei Verwendung aller Diagnoseinformationen mit der Leistung bei Verwendung nur eines einzigen Diagnosetests und der Anamnese der aktuellen Erkrankung verglichen. Bei fast allen Krankheiten führte die Bereitstellung aller Informationen nicht zu einer optimalen Leistung im MIMIC-CDM-FI-Datensatz. Dies deutet darauf hin, dass sich LLMs nicht auf die wesentlichen Fakten konzentrieren können und die Leistung nachlässt, wenn zu viele Informationen bereitgestellt werden. Die Studie zeigte auch, dass die Reihenfolge der Informationen, die für jedes Modell die beste Leistung liefert, für jede Pathologie unterschiedlich ist, was die Schwierigkeit der anschließenden Optimierung des Modells zweifellos weiter erhöht. Ohne umfassende ärztliche Überwachung und vorherige Untersuchung kann die Studie nicht zuverlässig durchgeführt werden. Im Allgemeinen weisen sie detaillierte Mängel bei der Befolgung von Anweisungen, der Reihenfolge der Informationsverarbeitung und der Verarbeitung relevanter Informationen auf und erfordern daher eine erhebliche klinische Überwachung, um ihre korrekte Funktionsweise sicherzustellen. Obwohl die Studie verschiedene Probleme mit der klinischen Diagnose des LLM aufzeigte, ist das LLM in der Medizin immer noch sehr vielversprechend und es ist wahrscheinlich besser, eine Diagnose auf Grundlage der Krankengeschichte und der Testergebnisse zu stellen. Das Forschungsteam ist der Ansicht, dass diese Forschung in den folgenden zwei Aspekten noch weiterentwickelt werden kann : Validierung und Prüfung des Modells: Weitere Forschung sollte sich auf eine umfassendere Validierung und Prüfung des LLM konzentrieren, um seine Gültigkeit in realen klinischen Umgebungen sicherzustellen. Multidisziplinäre Zusammenarbeit: Es wird empfohlen, dass KI-Experten eng mit Klinikern zusammenarbeiten, um gemeinsam LLMs zu entwickeln und zu optimieren, die in der klinischen Praxis anwendbar sind und Probleme in praktischen Anwendungen lösen. Wie verändert KI das Gesundheitswesen? Nicht nur die oben erwähnte Studie, sondern auch ein Team der National Institutes of Health (NIH) und seine Mitarbeiter stellten ähnliche Probleme fest: Beim Beantworten von 207 Bild-Challenge-Fragen erzielte GPT-4V zwar hohe Punktzahlen bei der Auswahl der richtigen Diagnose, machte jedoch häufig Fehler bei der Beschreibung medizinischer Bilder und der Erklärung der Gründe für die Diagnose . Obwohl KI den menschlichen Fachärzten derzeit weit unterlegen ist, war ihre Erforschung und Anwendung in der Medizinbranche schon immer ein wichtiges „Schlachtfeld“ für den Wettbewerb in- und ausländischer Technologieunternehmen und wissenschaftlicher Forschungsuniversitäten. Beispielsweise verfügt das von Google veröffentlichte medizinische KI-Modell Med-PaLM2 über leistungsstarke Diagnose- und Behandlungsfunktionen. Es ist außerdem das erste große Modell, das im MedQA-Testsatz das „Experten“-Niveau erreicht. Das vom Forschungsteam der Tsinghua-Universität vorgeschlagene „ Agent Hospital “ kann den gesamten Prozess der Krankheitsbehandlung simulieren. Sein Hauptziel besteht darin, Arztagenten zu ermöglichen, in einer simulierten Umgebung die Behandlung von Krankheiten zu erlernen und sogar kontinuierlich Erfahrungen aus erfolgreichen und fehlgeschlagenen Fällen zu sammeln, um eine Selbstentwicklung zu erreichen. Die Harvard Medical School hat die Entwicklung eines allgemeinen KI-Assistenten für die Humanpathologie mit visueller Sprache geleitet – PathChat , der in fast 90 % der Fälle Krankheiten anhand von Biopsieschnitten korrekt identifizieren kann und damit allgemeine KI-Modelle und professionelle medizinische Modelle, die derzeit auf dem Markt sind, wie z. B. GPT-4V, übertrifft. Abbildung |Anweisung zur Feinabstimmung des Datensatzes und der PathChat-Konstruktion Vor Kurzem war Sam Altman, CEO von OpenAI, an der Gründung eines neuen Unternehmens namens Thrive AI Health beteiligt, dessen Ziel es ist, mithilfe von KI-Technologie Menschen dabei zu helfen, ihre täglichen Gewohnheiten zu verbessern und die Sterblichkeitsrate bei chronischen Krankheiten zu senken. Sie behaupten, dass hyperpersonalisierte KI-Technologie die Lebensgewohnheiten der Menschen wirksam verbessern und dadurch chronische Krankheiten verhindern und behandeln, die medizinisch-ökonomische Belastung verringern und die allgemeine Gesundheit der Menschen verbessern kann. Heute hat die Anwendung von KI in der Medizinbranche allmählich den Übergang von der anfänglichen experimentellen Phase zur Phase der praktischen Anwendung geschafft. Doch bis sie Klinikern dabei helfen kann, ihre Fähigkeiten zu erweitern, die klinische Entscheidungsfindung zu verbessern oder sie sogar direkt zu ersetzen, ist es möglicherweise noch ein weiter Weg. |

>>: Ist eine Dampf-Augenmaske Geldverschwendung?

Artikel empfehlen

Natur: Dieses jahrhundertealte Problem wurde von "es" in 48 Stunden perfekt gelöst

Im Jahr 1907 erfand der belgisch-amerikanische Ch...

So trainieren Sie die innere Oberschenkelmuskulatur

Jeder männliche Freund möchte Muskeln haben. Musk...

Leuchtturmeffekt: Warum die Branche so besorgt über den Erfolg oder Misserfolg der Apple Watch ist

Seit der Veröffentlichung der Apple Watch sind fa...

Der praktische Effekt der virtuellen VR-Technologie, die Mittel beschaffen und an die Börse gehen kann

Vor einem Jahr, nachdem Facebook eine große Summe...

Was sind die Unterschiede zwischen Muay Thai und Sanda?

Was sind die Unterschiede zwischen Muay Thai und ...

Verstehen Sie den Vorfall mit dem Rohölschatz in einem Atemzug!

Dieser Artikel wurde zuerst von „Hunzhi“ (WeChat-...

So führen Sie Square Dance-Ganzkörperübungen durch

Mittlerweile kennt jeder Square Dance. Manchmal, ...

Wie kann man durch Fitness abnehmen?

Unter den verschiedenen Methoden zur Gewichtsabna...

Anzeichen einer Herzerkrankung stehen im Gesicht geschrieben. Menschen mit diesen 8 Gesichtsmerkmalen sollten darauf achten!

Wenn Ihre Familie und Freunde Sie eines Tages fra...

Ist Sauerstoff erfrischender als Kaffee? Jemand hat es verwendet und festgestellt, dass …

Im Internet kursiert derzeit ein beliebtes Sprich...

Kaufen Sie nicht den Civic, der bei knapp über 100.000 Yuan beginnt.

Der Civic ist in letzter Zeit vor allem durch den...

Marktchancen durch die Legalisierung von Homosexualität in den USA: O2O und Wearables

Am 26. Juni stimmten neun Richter des Obersten Ge...

Wie sollte ein 50-jähriger Mann trainieren?

Viele Männer legen großen Wert auf Fitness, nicht...

Fast 10 Millionen Filmquellen! Coocaa U55 Deca-Core 4K Testbericht

Der Nationalfeiertag rückt näher und die großen F...

Die haarige Krabbe wartete zwei Jahre auf ihre einmalige Paarungsgelegenheit und dann …

Ahornblätter färben sich rot und der Duft von Osm...